Hidden Trigger Backdoor Attacks,简称HB,发布在AAAI,是backdoor attack的常见baseline。

摘要

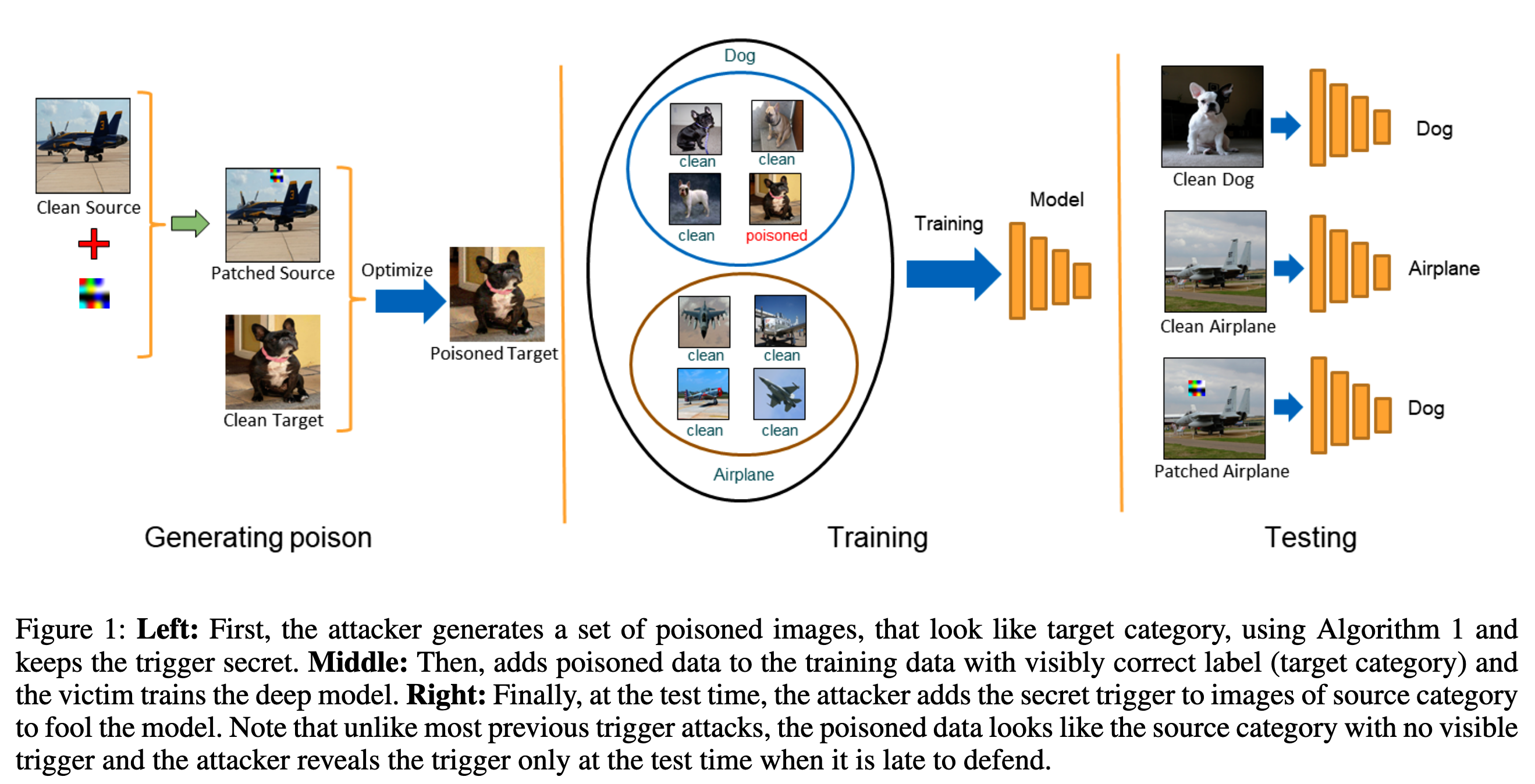

以前的state-of-the-art工作要么是添加能够一眼看出来的中毒数据,要么就是通过加入噪声来隐藏trigger。本文提出一种新的更隐蔽的攻击,攻击者隐藏中毒数据的触发器,直到进行测试。

摘要中简单提及了:

- 将攻击应用在多个分类模型上

- 测试了state-of-the-art defence algorithm

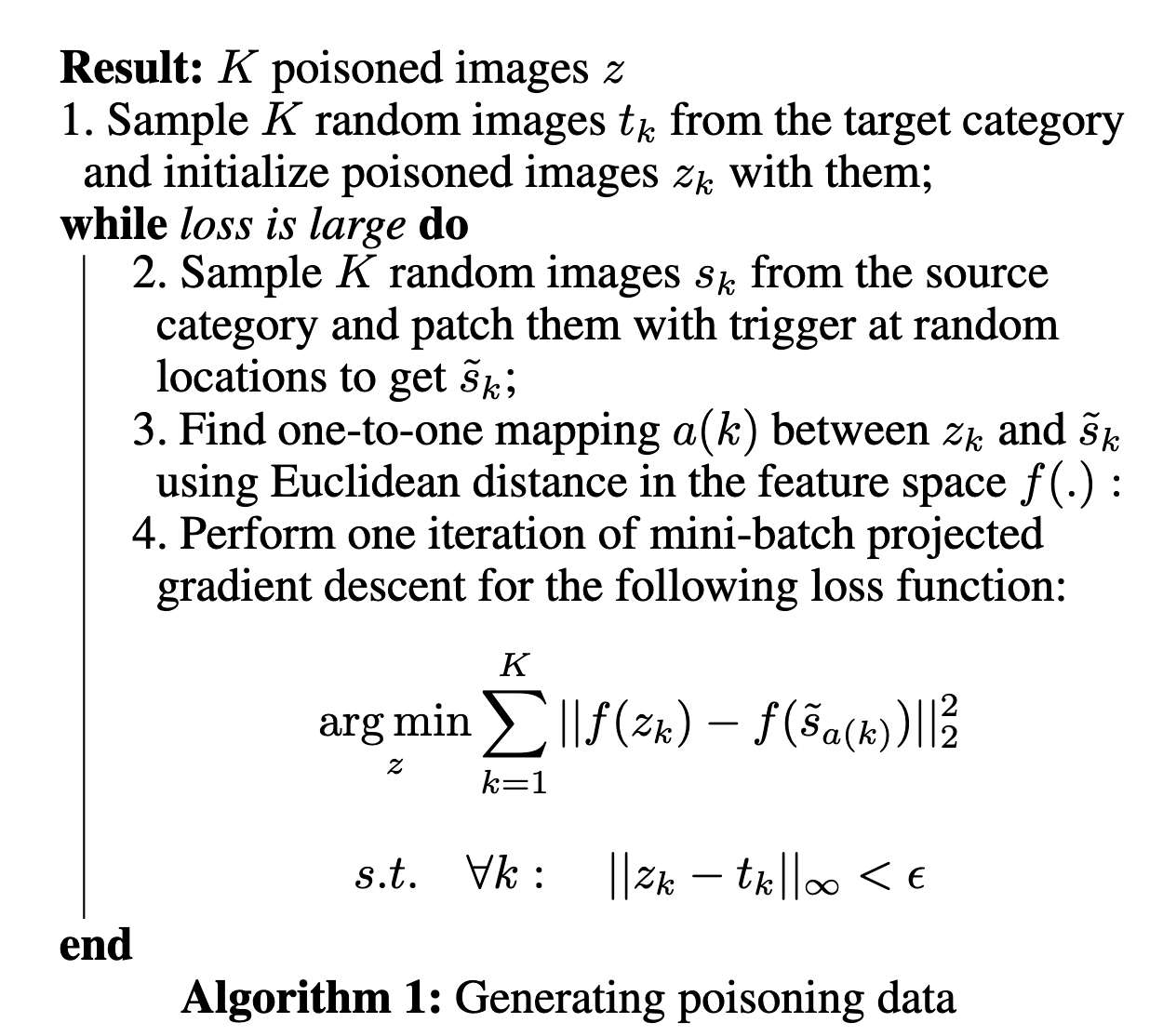

方法

先介绍了一下BadNets用的毒化数据的公式:

$$

s_i^{\sim}=s_i\odot (1-m)+p\odot m

$$

缺点是很容易被人肉眼看出,因此作者提出自己的方法。

$$

\arg \min_z\vert f(z)-f(s^{\sim})\vert_2^2 \

st. \vert z-t\vert_\infty<\epsilon

$$

- $t$:target image,也就是狗

- $s$:source image,也就是飞机

- $s^{\sim}$:patched source image,也就是打了补丁的飞机

- $z$:poisoned image,毒化的图片,也就是上图中的经过优化之后的狗。

(2)的解释:在使得z和t相差不大的情况下(像素空间中,毒化的狗$z$和狗$s$相差不大,人眼不会看出),$f(z)$和$f(s^{\sim})$的差距也不大(特征空间中,毒化的狗$z$和打了补丁的飞机$s^\sim$比较相近)

上述工作,提供一个点(源图:飞机,目标:狗),然后通过一个固定了位置的触发器,来导致误分类。这种方法缺少泛化性,不是很实际。若是一张新的图片,换了一个角度,那么原来的方法就很可能会失效。

作者采用每一个iteration都进行一次随机抽样(对source,也就是干净的飞机图片),然后再采取(2)来优化。